《1、 引言》

1、 引言

近几十年来,成像技术得到了快速的发展(例如,从模拟到数字,从单镜头到多相机,从百万像素级到十亿像素级)。尽管成像分辨率有了显著提高,但基本的原理保持不变,传统的成像系统严格遵循单一前馈路径,得到的图像质量受到拍摄过程中光学镜头与光电传感器分辨率的制约。图像拼接[1‒3]和传感器扫描[4‒8]可以显著提高成像系统的像素数,实现十亿像素级的成像。然而,这种成像范式只是在时空上简单地拼接每一个传感器的信息,并没有利用场景和实例级对象的时空关联关系,导致了成像系统硬件十分复杂,数据严重冗余。

相比之下,人类视觉系统具备双向通路机制,能够利用记忆能力,使用过去的观测为现在或者未来服务[9]。先从图像中提取信息并巩固成记忆印迹(大脑中稳定语义记忆的表征[9‒12]),随后通过反馈通路重新激活相关的印迹来进行记忆检索。具体地,在记忆印迹形成后[9‒12],对象的局部细节信息首先被传递到海马体。然后,海马体-皮层网络之间的循环关联会逐渐加强和巩固皮层上的记忆印迹,并由前额皮质(PFC)从中提取语义信息[9,13]。同时,PFC会判断输入的视觉信息是否与先前存储的皮层印迹相对应,并决定接下来的过程是巩固还是抑制。综上所述,这些双向动态信息传递实现了高效、稳健和自适应的视觉感知和理解。

受此启发,本文提出了一种具备双向通路的成像机制,称为“记忆成像”。首先,我们先提取大场景的整体表征,将实例级的局部对象抽象为记忆印迹,再建立场景与局部对象的双向关联关系来实现感知与理解。类似地,视觉信息首先由虚拟眼睛捕获,经PFC模块进行预处理。PFC模块会确定哪些信息已经存储在视频内存中,我们称其为激发-抑制状态,在这个状态下,像素细节被动态地巩固或抑制,以强化实例对象的记忆印迹。这种动态系统模仿人类的记忆机制,类似于“熵平衡”这一原理[14‒15]。直观上,为了有效维持有限大小的记忆容量,通常鼓励通过熵的最大化来增加记忆的有效信息量。随后,在关联状态下,通过检索记忆印迹,生成对象的时空上一致的内容,实现高分辨的成像。记忆成像的原理如图1所示。

《图1》

图1 记忆成像的原理图。它由激发-抑制状态和关联状态组成,像素级细节在动态的巩固或抑制过程中强化实例的记忆印迹;关联状态由记忆印迹驱动合成时空一致的高分辨对象图像内容。

实验结果表明,本文提出的记忆成像系统只需5%的高分辨率观测值和95%的低分辨率观测值,就可以生成高分辨的场景和动态对象实例图像,将为图像/视频的感知、重建、理解和编码存储探索新的方向,有望引领下一代成像系统的研究。

《2、 相关研究》

2、 相关研究

目前已有大量围绕人类视觉记忆印迹、超分辨率算法以及高分辨率成像系统进行的研究,以下将简要回顾这些内容。

《2.1 人类视觉印迹》

2.1 人类视觉印迹

人脑对视觉信息的感知和处理分为两个层次[16]。在低级视觉处理中,大脑视觉皮层通过前馈层次结构信息处理局部视觉特征,如颜色、对比度、方向和动作。在高级视觉处理中,记忆印迹是意识体验不可或缺的组成部分。物体识别尤其依赖于观察者过去的记忆印迹[16]。

记忆印迹这个术语是Semon在100多年前创造的,是对更稳定记忆的表征[9‒12]。普遍的观点是,大脑中的记忆印迹可能随着时间的推移而改变[9‒12]。具体来说,视觉信息最初是在海马-皮层的印迹中并行编码的,海马-皮层网络之间的循环关联逐渐强化了皮层印迹,巩固了记忆。在这个过程中,PFC从已有的皮层印迹中提取出语义信息,然后判断输入的视觉信息是否与先前存储的皮层印迹相对应,从而决定接下来的过程是巩固还是抑制[13]。在信息理论中,香农熵是衡量数据中所包含的信息量的度量,本文借鉴这一思想,提出了记忆熵,用于对记忆印迹中实例视觉信息的不确定性进行编码。记忆熵可以看作是经典香农熵的扩展,因为本文不直接计算熵,而是使用特征向量之间的距离来表示相对熵变化。

《2.2 超分辨率算法》

2.2 超分辨率算法

图像/视频的超分辨率算法旨在从低分辨率输入中恢复高分辨率细节。最常用的超分辨率方法是单图像超分辨率(SISR)。早期的研究主要利用稀疏性[17‒20]或参考图像块[21‒22]等低层图像先验。随后,深度神经网络的发展为这个领域带来了新的工具。Kim等[23]首先提出了一种用于单图像超分辨率的三层神经网络。研究人员随后利用20层深度神经网络[23]、递归结构[24‒25]和密集结构[26]对其做了进一步改进。然而,这些方法通常采用像素级均方差(mean squared error)损失函数,通常会导致结果过于平滑而缺少细节。因此,感知损失被引入图像/视频超分辨率中。Johnson等[27]将传统的像素级损失和VGG网络的特征空间损失结合起来,率先提出了结合实时风格转移和超分辨率的感知损失。Ledig等[28]提出了超分辨率生成对抗网络(SRGAN),能够实现自然图像高性能的4倍超分辨效果。

随着图像超分辨的倍率提升(>8倍),SISR的效果会越来越有限,因为在下采样过程中高频细节已经完全丢失。因此,研究人员开始探索基于参考对象的超分辨率方法(RefSR)。Boominathan等[29]以数码单反(DSLR)相机图像为参考图,提出了一种基于图像块匹配(patchmatch)的超分辨算法,在光场图像超分辨任务上取得了很好的效果。Wu等[30]对该算法进行了改进,提出一种更好的基于字典学习重构的图像块匹配算法。Wang等[31]通过迭代图像块匹配步骤,丰富了参考图像数据库,提高了超分辨质量。Zhang等[32]提出了超分辨率神经纹理转移算法(SRNTT),在神经网络的特征空间中进行多层次的块匹配。上述方法只使用了局部图像块信息,往往导致这些算法在混合焦距相机系统采集的真实数据下的超分辨率结果不佳。Tan等[33]和Zheng等[33‒34]提出了CrossNet和CrossNet++,一种端到端神经网络用于构建输入低分辨图像与高分辨参考图像之间的对应关系。与基于图像块匹配的方法相比,当输入图像与参考图像比较接近时,该方法能够建立可靠的图像对应关系,有效提高超分辨的效果。

《2.3 高分辨率成像系统》

2.3 高分辨率成像系统

除了超分辨率算法,研究人员还开发了强大的成像系统来提高分辨率。Kopf等[35]设计了一种用于拍摄静态十亿像素画面的电动云台。Brady等[3]制造了世界上第一台十亿像素相机“AWARE2”,配备有球形物镜和98个微相机,能够在一次拍摄中得到9.6亿像素的图像。其中,球形物镜需要精心设计和制造,以尽量减少像差对分辨率的影响[36‒37]。与AWARE2不同,Cossairt等[38]通过利用简单的单表面球形物镜和反卷积技术计算消除像差,来提高分辨率。用于十亿像素级全鼠脑成像的显微镜设计也采用了类似的想法[39]。然而,由于超高的分辨率带来的巨大的编码和计算压力,AWARE2每分钟只能录制三帧图像。为了降低计算复杂度,Yuan等[40]提出了非结构多尺度图像传感器阵列,通过空间非均匀的成像大大降低了亿像素级成像的带宽和算力需求。Zhang等[1]将这一想法扩展到虚拟现实(VR)应用中,实现三维亿像素级成像。非结构多尺度图像传感器阵列虽然降低了空间冗余,但时间冗余依然存在,仍然需要大量的像感器才能实现大场景多对象的感知和重建。

《3、 方法》

3、 方法

本文提出了记忆成像,它包含一个用于巩固场景信息的前馈通路以及一个用于关联印迹来推断和合成未来内容的反馈通路。本文的主要贡献在于建立了一个由印迹神经循环的功能模块组成的高级神经形态成像系统[9‒10,12]。如图2和图3所示,该成像系统由三个主要模块组成:实例观测模块、实例印迹模块和印迹处理单元(EPU),分别对应人脑海马区、皮质记忆区和PFC。前两者负责低级和高级信息的表征,后者负责信息的提取和控制。

《图2》

图2 记忆印迹生成的前馈通路。

《图3》

图3 印迹驱动影像合成的反馈途径。印迹关联模块用来匹配观测值与印迹之间的特征向量。然后将这两个向量连接起来,并输入到合成模块。

在前馈通路中(图2),提出利用熵平衡法则将低级观测中的有效信息整合到印迹中,同时抑制无意义信息。在反馈路径中(图3),预先生成的印迹与新的观测相关联,用来合成高质量的未来内容。

《3.1 成像记忆熵与熵平衡原则》

3.1 成像记忆熵与熵平衡原则

本文用熵来量化对象记忆印迹的信息量(即描述实例记忆印迹的潜在不确定性程度)。熵是一个用于描述系统从有序到无序的过程的术语(熵较小的随机变量具有较高的可预测性,因此不确定性低)[41]。在本文中,被抽象成记忆印迹的视觉观测用概率密度函数

(1)

其中,E表示期望运算符。

直观上,当两个样本、在特征空间中接近时,用一个样本来表示另一个样本更为合理。预测置信度可以使用带有均值向量

(2)

其中,

人类的工作记忆能存储的信息量是有限的,与之类似,成像系统的记忆容量也是有限的,因此可被快速访问以满足持续不断的拍摄任务的需要。因此,需要一种记忆印迹的更新机制,其目标是最大化记忆印迹的信息量。

此处定义记忆状态

(3)

(4)

其中,第k个观测是有限记忆印迹中最多余的(信息量最少的);第q个观测代表新增的观测。

当新增样本替代了有限记忆印迹中信息量最少的样本之后,如果系统熵增加[即

在实施过程中,如何计算熵值是印迹更新策略的关键。根据近似方法[52],混合熵的边界为:

(5)

此处,

最后,根据更新策略对新的观测进行动态的巩固或抑制,从而增加记忆印迹的信息量。

《3.2 前馈通路》

3.2 前馈通路

图2展示了生成记忆印迹的前馈通路。场景和对象首先被虚拟眼睛(相机)捕获成图像像素,经预处理后被保存为前景动态对象和背景。在本文中,用Faster R-CNN网络[42]和Mask R-CNN网络[43]进行感兴趣对象的检测和分割。然后,用编码器从图像中提取高级语义信息。本文用五个卷积层来提取特征向量,每层有64个5 × 5大小的滤波器。前两层的步长设为1,后三层的步长设为2,目的是生成多尺度特征图,组成特征向量。随后,根据熵平衡原则来决定是将信息整合到记忆印迹中还是将其抑制。

(1)虚拟眼睛。虽然人眼有大约0.576亿像素,但只有中心窄视场的分辨率很高[44‒45],周围视场的分辨率比较低。通过眼球的扫视活动,人眼能在大脑中生成清晰的宽视场图像,实现高效的信息捕获和整合。本文模仿人眼设计了一种混合摄像系统:用一个广角全局相机拍摄低分辨率的全景,几个具有长焦镜头的局部相机来捕捉感兴趣的细节。

(2)熵平衡。通过将最小成对距离

《3.3 反馈通路》

3.3 反馈通路

在生成记忆印迹后,本文利用反馈通路在记忆印迹的驱动下,从低分辨实例观测中预测合成高分辨实例图像。如图3所示,利用训练好的记忆印迹关联模块,可以从记忆印迹中检索最为匹配的特征向量(即成对距离最小的特征向量,用“印迹向量”表示)。最后,将两个特征向量连接起来,使用合成网络模块生成高分辨率图像[33‒34]。

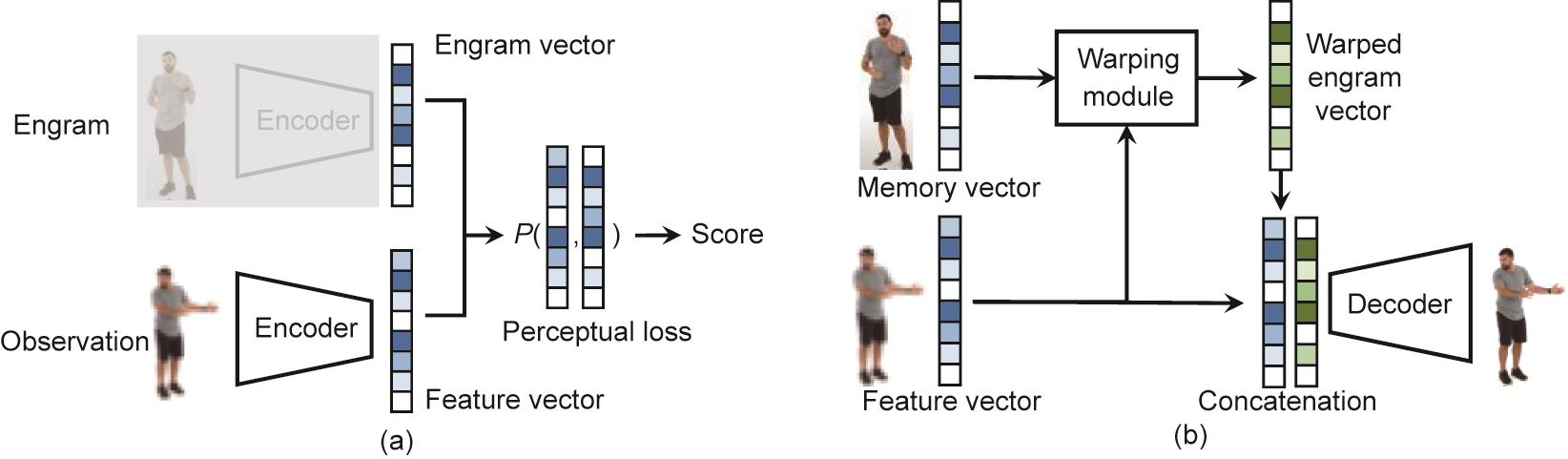

(1)印迹关联。印迹关联的目的是找到能生成最佳高分辨率图像的印迹向量。这意味着所选印迹向量应该接近观测的特征向量。现有的图像损失函数[27]难以准确评估大分辨率差距下的相似度。因此,本文通过训练新的成对损失函数来实现印迹关联模块,如图4(a)所示。观测的特征向量由新训练的编码器得到,而印迹向量则直接从高级印迹中提取,最后使用感知损失来估算相似性得分。 由于很难获得相似性得分真值,本文采用成对排序损失训练网络[46]。在生成训练数据的过程中,遍历了所有的观测-印迹组合,采用合成图像的峰值信噪比(PSNR)对所有的印迹向量进行排序。结合此排名,利用成对排序损失来训练网络。

《图4》

图4 反馈通路中两个子模块的网络结构。(a)印迹提取关联模块;(b)合成模块。P:感知损失。

(2)合成模块。如图4(b)所示,本文使用合成模块来重建高分辨图像。利用修改后的FlowNet网络[47‒48]建立特征向量和印迹向量之间的对应关系,将两个特征向量对齐并连接起来之后,用解码器生成高分辨率图像。解码器由一个包含64个滤波器的反卷积层组成(大小为4 × 4,步长为2)。解码器输出结果与真值之间的损失函数L的定义如下:

(6)

其中,

《4、 实验》

4、 实验

本文利用计算机合成数据和实际数据验证了提出的记忆成像系统,并进行了消融实验,验证了每个模块的有效性。

《4.1 数据准备》

4.1 数据准备

本文利用虚幻引擎在预定义的路径和场景中渲染虚拟人体模型来得到合成数据。主摄像头为具有90° FoV的宽视场视频,分辨率为8192 × 8192,每秒30帧。高分辨率视频作为真值,下采样得到的低分辨宽视场视频作为输入(广角全局相机)。从真值上截取了包含感兴趣对象的一小部分作为高分辨率小视场视频(长焦局部相机,模拟人眼的中心区域)。

除了计算机合成数据外,本文还搭建了多尺度相机阵列系统[50],录制真实视频来验证提出的记忆成像方法。由于阵列相机已经以亿像素级的分辨率覆盖了广角视场,本文从亿像素级图像中截取了包含感兴趣对象的区域作为高分辨率小视场视频,并用全局广角相机采集的内容作为低分辨宽视场视频。

《4.2 与传统成像系统对比》

4.2 与传统成像系统对比

图5展示了该印迹成像系统和传统成像系统在计算机合成场景下的结果,PSNR结果如表1所示。整个宽视场视频包含5个人,由高分辨率局部相机对所有人进行循环扫描。一个人的每个扫描周期包含一个高分辨率帧和19个低分辨率帧。结果表明,记忆成像系统能显著提高视觉效果。在传统成像系统中,一旦高分辨局部相机移到其他人身上,人物就会变得模糊,尤其是面部。本文提出的系统可以借助记忆印迹长时间维持高分辨率的人像。图5展示了两个对象的成像效果,记忆成像系统可以在记忆痕迹的帮助下复原面部和毛发的细节,如眼睛、鼻子和嘴巴等。

《图5》

图5 记忆成像在合成数据上的效果。

《表1》

表1 与不同序列的最先进方法进行定量比较

本文还在真实采集的视频上[50],用同样的扫描策略来生成高分辨局部相机的数据,并进行了实现(图6)。结果表明,记忆成像系统可以借助记忆印迹从分辨率非常低的观测中成功重建高分辨手指等小细节。

《图6》

图6 记忆成像在真实视频数据上的结果(动态)。红色和蓝色的轨迹表示两个对象的移动路径。

除了动态的对象外,记忆成像系统还可以通过高分辨局部相机的扫描来改善大场景背景图像的成像质量,如图7所示。与最先进的SISR、MDSR [51]和SRNTT算法[32]相比,我们的方法成功复原了可识别的汉字(红框)。如果没有记忆印迹的帮助,这几乎是不可能实现的。表1展示了PSNR的量化对比结果。

《图7》

图7 真实数据结果。从上到下分别为:低分辨率观测、SISR、MDSR[

《4.3 印迹关联模块的有效性验证》

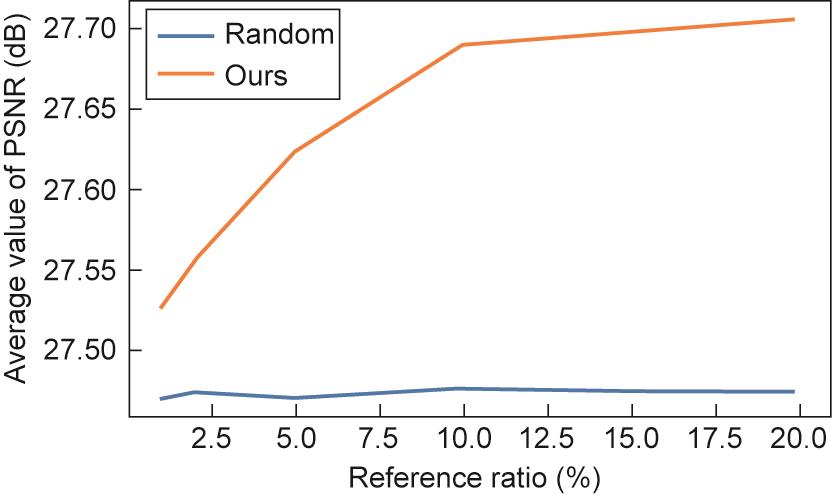

4.3 印迹关联模块的有效性验证

我们还通过实验验证了印迹关联模块的有效性。实验主要测试了以下两个因素:记忆印迹缓存的容量和关联策略。对于前者,选取2%、5%、10%和20%容量的视频,并检验其性能。对于关联策略,将训练好的策略模型与随机选定的方法进行比较。结果如图8所示。增加印迹容量提高了成像质量,但当超过10%时,效果便趋于稳定。经过训练的印迹关联模块的表现明显优于随机选择方法,特别是在印迹容量较小的情况下。

《图8》

图8 印迹关联模块的有效性。

《4.4 消融实验》

4.4 消融实验

通过消融实验来验证实例观测模块、实例印迹模块和印迹处理单元(EPU)在记忆成像系统中的有效性。

(1)去除印迹处理单元。EPU对应人脑的PFC。如果没有EPU,印迹关联模块很难找到属于同一人或物体的正确印迹向量。因此,从印迹整体中随机选择印迹向量。印迹向量也可以选自其他人或物体。

(2)去除实例印迹。实例印迹模块对应于人脑的皮质记忆区,负责保存提取和巩固的记忆印迹。缺少此模块,就无法巩固有用的特征向量,抑制无意义的特征向量。因此,只能选取相邻几帧图像作为印迹向量。

(3)去除实例观测。没有实例观测,系统将退化为SISR系统,因此只能将观测本身的特征向量当作印迹向量。

图9为消融实验结果。和预期一样,完整的记忆成像系统拥有最高的PSNR和最佳的视觉效果。缺少这三个模块中的任何一个,重建质量将急剧下降。

《图9》

图9 消融实验结果。w/o:有/无。

《5、 结论》

5、 结论

本文提出了一种具有前馈和反馈双向通路的记忆成像系统。受人类视觉系统启发,前馈通路提取实例表征,形成记忆印迹,反馈通路利用记忆印迹重建高分辨率图像。实验结果表明,记忆成像系统仅需5%的高分辨率观测值和95%的低分辨率观测值,就可以生成高分辨的图像。借助记忆痕迹,可以从低分辨观测中重建高分辨率细节,用于图像/视频超分辨率、便携式十亿像素成像、元宇宙等领域。我们相信,记忆成像技术将为图像/视频感知、重建、理解和存储探索新的途径,有望引领下一代视觉感知系统的发展。

京公网安备 11010502051620号

京公网安备 11010502051620号