《1 引言》

1 引言

自从1943年McCulloch与Pitts提出第一个人工神经元网络MP模型

在上述人工神经元网络模型中, 系统的输入均为与时间无关的常量, 即网络的输入是几何点式的瞬时输入。然而, 生物学研究表明

《2 过程神经元》

2 过程神经元

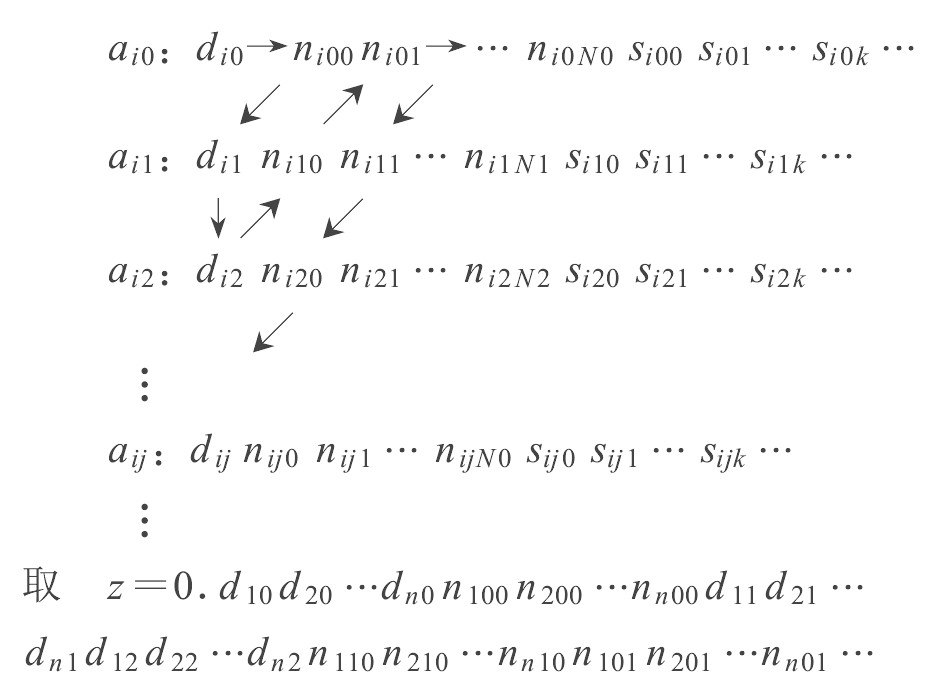

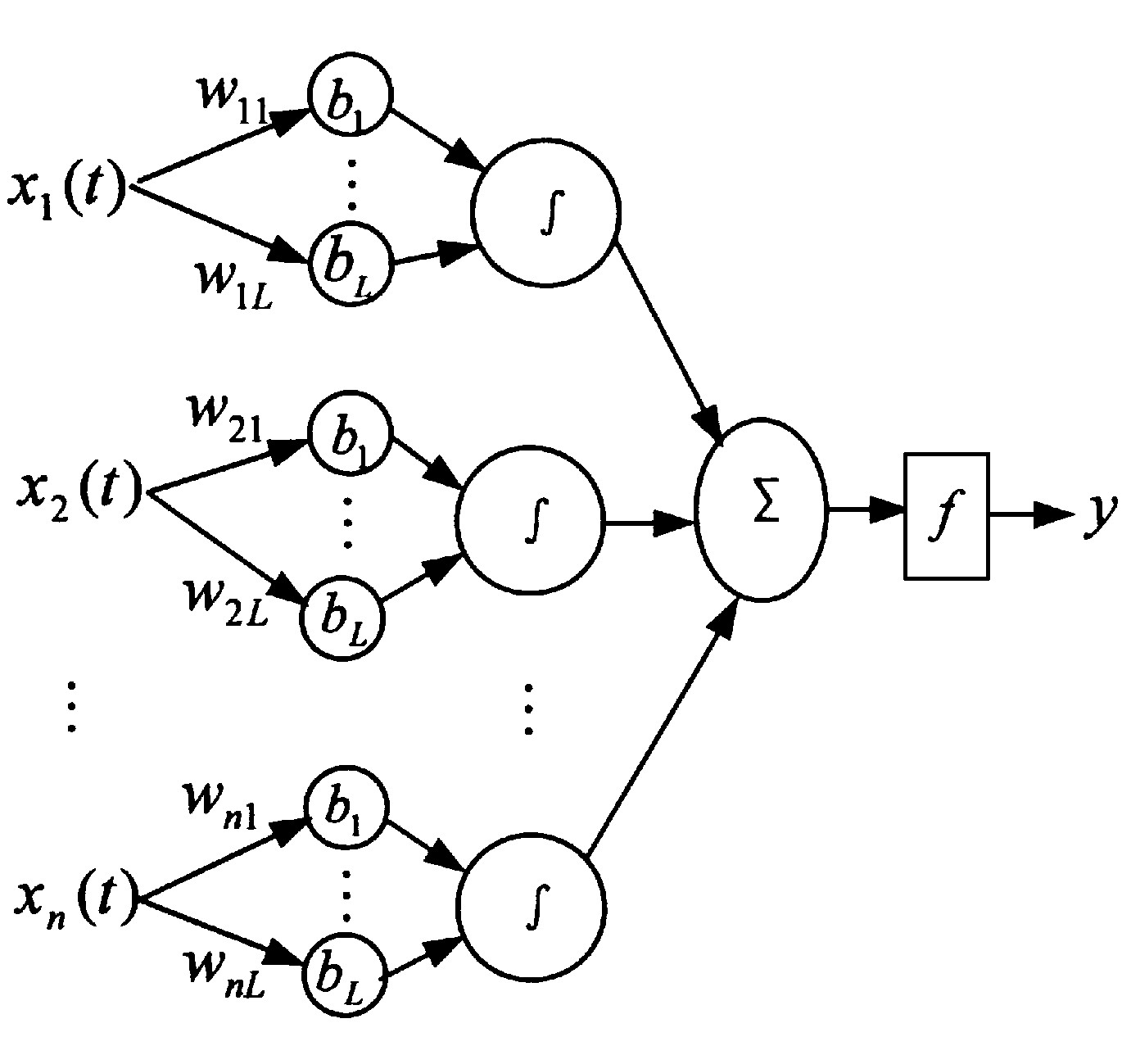

过程神经元由加权、聚合和激励三部分组成。单个过程神经元的结构图如图1所示。图1中, x1 (t) , x2 (t) , …, xn (t) 为过程神经元输入函数向量;w1 (t) , w2 (t) , …, wn (t) 为相应的权函数;K (t) 为过程神经元的时间聚合基函数;f (·) 为激励函数, 可取线性函数、Sigmoid函数、Gauss型函数等。

过程神经元的输入与输出之间的关系为

过程神经元的输入与输出之间的关系为

这里“⊕”表示某种空间聚合运算, “⨂”表示某种时间 (过程) 聚合运算。例如

其中K (·) 为[0, T]上的一个可积函数。或更一般地设K (·) 为一个一元泛函, 定义

一般假设权函数W (t) 和时间聚合基函数 (泛函) K (·) 均连续。由式 (1~3) 描述的过程神经元, 其内部运算由加权乘、积分、累加和以及激励函数组成, 称之为狭义过程神经元。

其实, 加权聚合运算“⊕”和“⨂”还可以取其它一般形式的运算, 例如用max和min, 或T-算子和S-算子来构成“⊕”, 激励函数f也可以是任何形式的有界函数。由式 (1, 2, 4) 描述的过程神经元被称为广义过程神经元。

《3 过程神经元网络模型》

3 过程神经元网络模型

由若干个过程神经元按一定的拓扑结构组成的网络称过程神经元网络。类似于传统神经元网络, 过程神经元网络也可以分前向型和反馈型网络。本文仅讨论前向型过程神经元网络。

定义一种其权函数可由一组基函数展开的过程神经元网络模型。设U是泛函空间S={f (x) |x=x (t) ∈Rn, t∈R, f (x) ∈V⊂Rm}上的一个紧致集, 为讨论简单起见, 取m=1, 即多输入单输出系统。也不难将结果推广到m>1的情况。假设过程神经元网络的权函数可被基函数B (t) 展开, 即将权函数的形式限制在一类较简单的函数类中来考虑问题。基函数B (t) 可以是有限基, 也可是可数基, 可以是正交的, 也可以是非正交的。这种过程神经元网络如图2所示。图2中首先把权函数按基展开, 中间各子层的运算如下:

或一般地有

其中θ为神经元的阈值, f为神经元的激励函数。函数 (泛函) K (·) 应根据实际需要来确定。

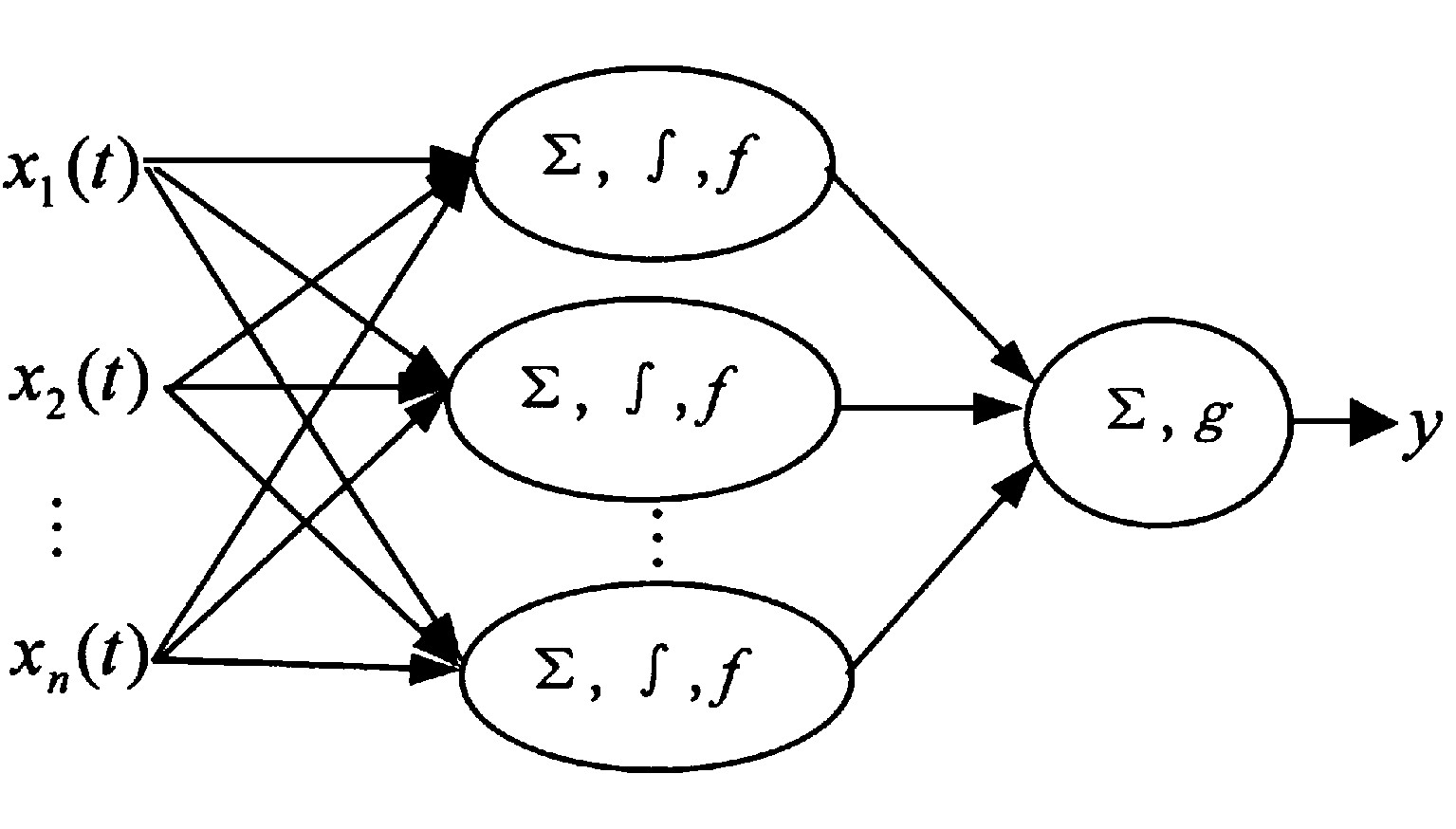

式 (7) 或式 (8) 表示的网络是一个单层过程神经元网络。下面讨论一种具有一个隐层的网络, 仍考虑多输入单输出系统, 网络的拓扑结构如图3所示。其中, 中间层 (隐层) 的各单元分别由图2中所示的神经元组成, 并设隐层有p个单元。各隐单元的激励函数和阈限可以相同, 也可以不同, 具有相同激励函数的网络称为正规过程神经元网络, 具有不同激励函数的网络称为混合过程神经元网络。输出层为一个非时变神经元。为简单起见, 仅讨论由式 (7) 定义的网络, 并设K (t) =1, 即

若假设输出层中g (u) =u, τ=0, 并令

则

《4 基本定理》

4 基本定理

一个合理的神经元网络模型必须具备一些最基本的特性, 包括连续性、逼近能力和计算能力等。本节就来讨论这些问题。

定理1 (连续性定理) 设式 (12) 的输入为x (t) , x* (t) ∈U , 相应的输出分别为y, y*∈V。若f连续, 则对任意的ε>0, 必存在δ>0, 当‖x (t) - x* (t) ‖<δ时, 有|y- y*|<ε。

证明:因f连续, 对任意的ε1>0, 存在δ1>0, 当|cj-c*j|=∫

定理2 传统前馈神经元网络是过程神经元网络的一种特例。

证明: 只需在式 (9) 中取xi (t) =xi, bi (t) =1, T=1, 则

即成为一个非时变的传统单隐层前馈神经元网络。

定义1 设K (·) :Rn→V⊂R为Rn到R上的任意连续函数, 记为K∈C (Rn) , 定义泛函类

定义2 设x (t) = (x1 (t) , x2 (t) , …, xn (t) ) T, 其中xi (t) 为[0, T]上的连续函数 (记为xi (t) ∈C[0, T]) , i=1, 2, …, n。对任意的t1, t2∈[0, T], 若 |xi (t1) -xi (t2) |≤L|t1-t2|, L≥0, 则称xi (t) 满足Lipschitz条件。若‖x (t1) - x (t2) ‖≤Lx |t1-t2|, Lx≥0, 则称x (t) 满足Lipschitz条件, 若|K (x (t1) ) -K (x (t2) ) |≤LK‖x (t1) -x (t2) ‖, 则称K (·) ∈C (Rn) 满足Lipschitz条件。

传统神经元网络的研究已经证明了下列熟知的逼近定理。

引理1

定理3 (逼近定理) 对任意的由定义1定义的连续泛函G (x (t) ) ∈∑n (K) 和ε>0, 若满足Lipschitz条件, 则存在过程神经元网络P, 使得 ‖G (x (t) ) -P (x (t) ) ‖<ε。

证明:任取G∈∑n (K) 和ε>0, 即

不失一般性, 设T=1, 将K看成关于t的复合函数, 并将积分区间N等分,

设计泛函

由于K (x (t) ) 对于t连续, 由积分中值定理, 存在

于是

其中, LK, Lx分别为K (x) 关于x和x (t) 关于t的Lipschitz常数。于是

记x (i) =x (ti) 。由于K (x (i) ) :Rn→V为C (Rn) 中的连续函数, 由引理1知可用一个传统神经元网络来逼近, 再由定理2, 该传统前馈神经元网络一定能够用一个过程神经元网络来替代。即

其中εi>0为任意小数, i=1, 2, …, N, 不妨取εi<ε/ (2N) 。 由式 (19) 知, 存在N0, 当N>N0时

记

则

P (x (t) ) 即为所求。

引理2 存在连续泛函K (·) , 使得对任意的x (t) = (x1 (t) , x2 (t) , …, xn (t) ) 和x* (t) = (x*1 (t) , x*2 (t) , …, x*n (t) ) , 当x (t) ≠x* (t) 时, 必有K (x (t) ) ≠K (x* (t) ) 。

证明:考虑x (t) 的第i个分量xi (t) ∈C [0, T], 可用如下多项式逼近:

其中, {aij∈R}, i=1, 2, …, n;j =0, 1, 2, …。 不妨设

其中, dij∈{0, 1}, pij∈Ν为自然数集合, sij∈ (0, 1) 。令

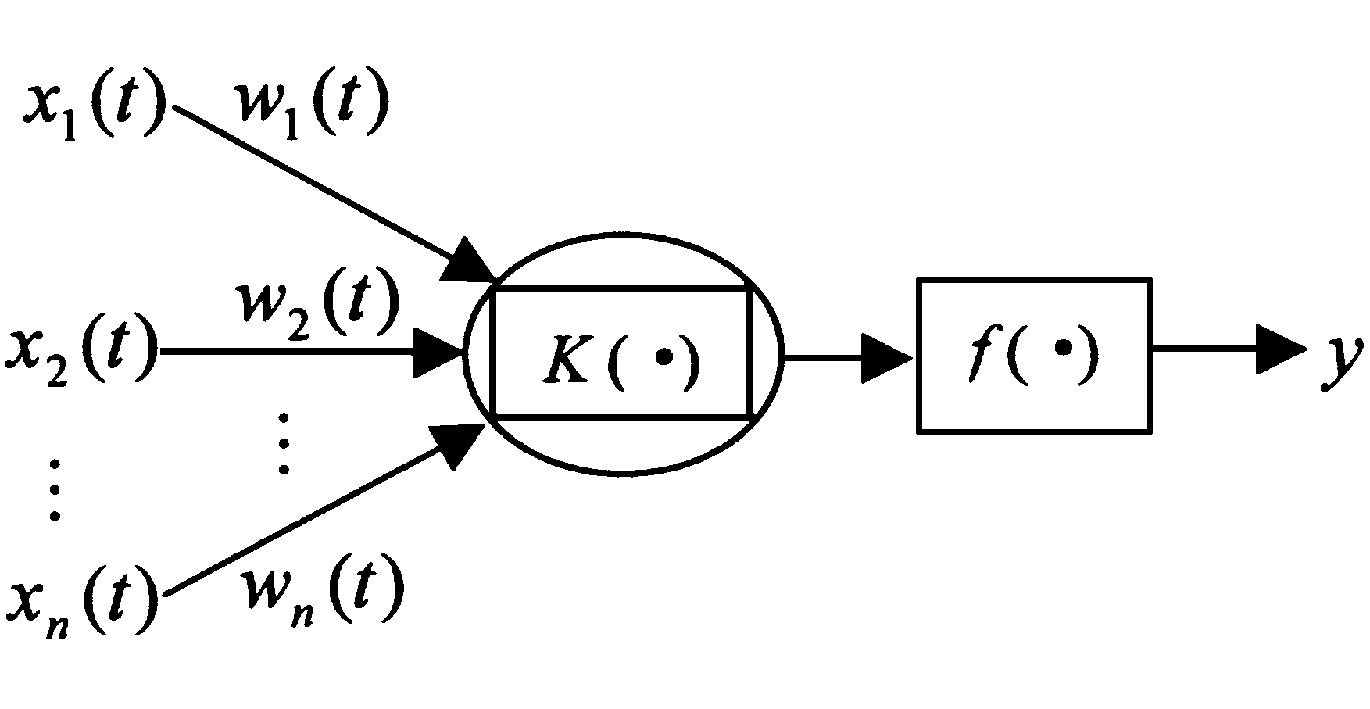

将aij, j=1, 2, … 作如下排列:

《图4》

即z的小数部分排列顺序为阵列中从左上角到右下按箭头所示, 并且对于每一个位置做i的从1到n排列。显然z∈[0, 1]。将此映射关系记为K, 显然K为一一映射, 由z的取法知K (·) 连续。

定理4 (逼近定理) 对任意的连续泛函G (x (t) ) :U⊂C (Rn) →V⊂R和ε>0, 存在过程神经元网络P, 使得 ‖G (x (t) ) -P (x (t) ) ‖<ε。

证明:按照引理2的构造方法, 把一个过程神经网络的逼近问题化成了一个传统神经网络的逼近问题, 根据引理1, 定理得证。

定理5 (计算能力定理) 狭义过程神经元网络的计算能力与图灵机等价。

证明:首先在狭义过程神经元网络中所用到的运算由式 (1~3) 知, 无非就是“+", “·", “∫" 以及它们的复合运算, 这些运算都可以用图灵机实现 (对“∫”运算只求近似值) , 故过程神经元网络的计算能力不会大于图灵机。另一方面, 由文献

《5 结论》

5 结论

本文提出了一类新的神经元网络——过程神经元网络的概念。并证明了相应的连续性定理, 逼近定理, 计算能力定理等重要理论结果。过程神经元网络是对生物神经元网络更贴切的模拟, 实际中很多应用可归结为此问题, 包括诸如某些化工和酿造等工业过程的建模和控制、农业领域内大棚栽培和室内养殖的调控和优化等。总之, 模型对于与过程有关的众多问题的解决具有广泛的应用前景。

京公网安备 11010502051620号

京公网安备 11010502051620号